فرق خزش و خراش وب: راهنمای جامع برای توسعهدهندگان

فرق خزش و خراش وب: راهنمای جامع توسعهدهندگان و متخصصان سئو. با الگوریتمهای خزش وب (Crawling) و تکنیکهای خراش وب (Scraping) آشنا شوید.

۱. خزش وب (Web Crawling) چیست؟

خزش وب، که با نامهای رباتگذاری یا اندیسگذاری نیز شناخته میشود، فرآیندی است که توسط خزندههای وب (Web Crawlers) یا باتهای موتور جستجو (Search Engine Bots) انجام میشود. هدف اصلی این خزندهها، مرور و تجزیه و تحلیل صفحات وب برای جمعآوری اطلاعات و افزودن آنها به پایگاه داده موتورهای جستجو مانند گوگل، بینگ و یاهو است.

۱.۱. نحوه عملکرد خزش وب

خزندهها با دنبال کردن لینکهای موجود در صفحات وب، از یک صفحه به صفحه دیگر حرکت میکنند. این فرآیند با یک لیست اولیه از URL ها آغاز میشود که به آنها “Seeds” یا “بذرها” گفته میشود. خزندهها این URL ها را دریافت کرده، محتوای آنها را میخوانند و لینکهای موجود در آن صفحات را استخراج میکنند. سپس این لینکهای جدید به لیست URL های پردازش نشده اضافه میشوند و فرآیند تکرار میگردد.

- پیمایش لینکها: این اصلیترین روش حرکت خزندهها است. آنها صفحات را با دنبال کردن تگهای “ (لینکهای هایپر) که به URL های دیگر اشاره دارند، کشف میکنند.

- فایل robots.txt: صاحبان وبسایتها میتوانند با استفاده از فایل

robots.txt، به خزندهها دستور دهند که کدام بخشها یا صفحات سایت را خزش نکنند. این مکانیزم به مدیران سایت اجازه میدهد تا کنترل بیشتری بر روی دسترسی رباتها داشته باشند. - نقشههای سایت (Sitemaps): فایلهای نقشه سایت (مانند

sitemap.xml) لیستی از تمام URL های مهم یک وبسایت را در اختیار خزندهها قرار میدهند و به آنها کمک میکنند تا ساختار سایت را بهتر درک کرده و صفحات را به طور کاملتری کشف کنند. - متا تگها: برخی متا تگها، مانند

noindex، به خزندهها اعلام میکنند که یک صفحه نباید در نتایج جستجو ظاهر شود.

۱.۲. اهداف خزش وب

هدف اصلی خزش وب، ساخت و بهروزرسانی پایگاه داده موتورهای جستجو است. این اطلاعات سپس برای نمایش نتایج جستجو به کاربران استفاده میشود. موتورهای جستجو از اطلاعات جمعآوری شده توسط خزندهها برای فهرستبندی (Indexing) صفحات وب و رتبهبندی آنها بر اساس معیارهای مختلف (مانند مرتبط بودن، کیفیت محتوا، تجربه کاربری و غیره) استفاده میکنند.

۱.۳. تفاوت خزش وب با نمایهسازی (Indexing)

اگرچه خزش وب و نمایهسازی (Indexing) اغلب با هم انجام میشوند، اما دو مرحله متفاوت هستند:

- خزش: کشف و دانلود صفحات وب.

- نمایهسازی: تجزیه و تحلیل محتوای صفحات خزش شده و سازماندهی آن به شکلی که موتور جستجو بتواند آن را برای پاسخ به جستجوهای کاربران بازیابی کند.

۲. خراش وب (Web Scraping) چیست؟

خراش وب، که با نامهای استخراج دادههای وب یا کَندن وب نیز شناخته میشود، فرآیندی است که طی آن دادهها به صورت خودکار از وبسایتها جمعآوری و استخراج میشوند. برخلاف خزش وب که توسط موتورهای جستجو برای فهرستبندی انجام میشود، خراش وب معمولاً توسط افراد یا شرکتها برای اهداف تجاری، تحقیقاتی، تجزیه و تحلیل بازار، جمعآوری اطلاعات رقبا، مقایسه قیمتها یا سایر کاربردهای خاص انجام میگیرد.

۲.۱. نحوه عملکرد خراش وب

خراش وب معمولاً با استفاده از ابزارها یا اسکریپتهای سفارشی انجام میشود. این ابزارها صفحات وب را بارگیری کرده و سپس ساختار HTML آنها را تجزیه و تحلیل میکنند تا دادههای مورد نظر را از عناصر خاص (مانند تگهای HTML، کلاسها، شناسهها و غیره) استخراج کنند.

- استفاده از کتابخانهها و ابزارها: زبانهای برنامهنویسی مانند پایتون با کتابخانههای قدرتمندی مانند Beautiful Soup و Scrapy، ابزارهای رایج برای خراش وب هستند. ابزارهای دیگری نیز مانند Octoparse، ParseHub و Web Scraper وجود دارند که امکان خراش وب را بدون نیاز به کدنویسی نیز فراهم میکنند.

- شناسایی الگوها: استخراجکنندگان وب الگوهای مشخصی را در ساختار HTML هدف جستجو میکنند. این الگوها میتوانند شامل نام کلاسها، شناسهها، یا ساختار سلسله مراتبی تگها باشند.

- استخراج و ذخیرهسازی داده: پس از شناسایی و استخراج دادههای مورد نظر، آنها در فرمتهای ساختاریافته مانند CSV، JSON یا پایگاه داده ذخیره میشوند.

۲.۲. اهداف خراش وب

خراش وب اهداف بسیار متنوعی دارد، از جمله:

- جمعآوری قیمت محصولات: برای مقایسه قیمتها بین فروشندگان مختلف.

- تحلیل بازار: جمعآوری اطلاعات در مورد روندها، محصولات جدید و فعالیت رقبا.

- جمعآوری اطلاعات تماس: برای مقاصد بازاریابی یا شبکهسازی.

- جمعآوری دادههای تحقیقاتی: برای پروژههای دانشگاهی یا تحقیقات علمی.

- نظارت بر اخبار و رسانهها: جمعآوری مقالات و گزارشهای مربوط به یک موضوع خاص.

- آموزش مدلهای یادگیری ماشین: جمعآوری حجم زیادی از دادههای متنی یا تصویری.

۲.۳. ملاحظات قانونی و اخلاقی در خراش وب

خراش وب میتواند پیامدهای قانونی و اخلاقی داشته باشد. برخی وبسایتها صراحتاً خراش وب را در شرایط خدمات خود ممنوع کردهاند. همچنین، استخراج حجم زیادی از داده میتواند باعث فشار بر سرورهای وبسایت هدف شود و عملکرد آن را مختل کند. توجه به robots.txt و احترام به سیاستهای وبسایتها در هنگام خراش وب ضروری است.

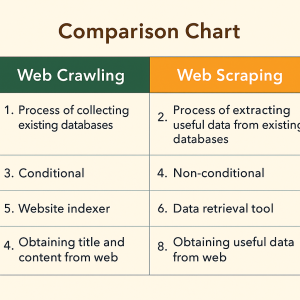

۳. فرق خزش و خراش وب: مقایسهای جامع

برای درک بهتر فرق خزش و خراش وب، بیایید آنها را در ابعاد مختلف مقایسه کنیم:

| ویژگی | خزش وب (Web Crawling) | خراش وب (Web Scraping) |

|---|---|---|

| هدف اصلی | فهرستبندی صفحات برای موتورهای جستجو، کشف محتوا. | استخراج دادههای خاص برای تجزیه و تحلیل، استفاده تجاری یا تحقیقاتی. |

| فاعل (فاعل) | رباتهای موتور جستجو (مانند Googlebot). | اسکریپتها یا نرمافزارهای سفارشی، ابزارهای تجاری. |

| دامنه فعالیت | کل وب یا بخش بزرگی از آن برای ساخت پایگاه داده. | معمولاً بخشهای خاص و مورد نظر یک یا چند وبسایت. |

| نوع داده | جمعآوری کلیه محتوای قابل دسترس (متن، لینک، تصاویر). | استخراج دادههای ساختاریافته و مورد نیاز (قیمت، نام محصول، مشخصات). |

| تکرارپذیری | تکرارپذیر و مداوم برای بهروزرسانی پایگاه داده. | بسته به نیاز و هدف، میتواند یکباره یا دورهای باشد. |

| کنترل | توسط موتور جستجو کنترل میشود. | توسط کاربر یا توسعهدهنده ابزار خراش وب کنترل میشود. |

| ملاحظات قانونی | عموماً با رضایت ضمنی صاحبان وبسایت (از طریق robots.txt). | نیاز به توجه بیشتر به شرایط خدمات و قوانین کپیرایت. |

| پیامدهای احتمالی | بهبود رتبه در نتایج جستجو، افزایش ترافیک ارگانیک. | مشکلات قانونی، مسدود شدن IP، فشار بر سرور. |

| مثال کاربرد | گوگلبات که صفحات وب را برای نتایج جستجو فهرستبندی میکند. | جمعآوری قیمت محصولات از سایتهای فروشگاهی برای مقایسه. |

۳.۱. نمودار مقایسهای

برای روشنتر شدن فرق خزش و خراش وب، یک نمودار مقایسهای ارائه میدهیم:

۳.۲. همپوشانیها و تمایزهای ظریف

در حالی که فرق خزش و خراش وب در اهداف اصلیشان مشخص است، گاهی اوقات ابزارهای خراش وب نیز ممکن است صفحات را به طور کامل پیمایش کنند، شبیه به خزش. اما نکته کلیدی اینجاست که در خراش وب، تمرکز بر استخراج دادههای خاص است، نه جمعآوری اطلاعات برای نمایهسازی جهانی. به عنوان مثال، یک ابزار خراش وب ممکن است از یک خزنده برای یافتن صفحات محصولات استفاده کند، اما هدف نهایی، گرفتن قیمت و مشخصات آن محصولات است، نه فهرستبندی خود صفحه محصول در یک موتور جستجو.

۴. اهمیت فرق خزش و خراش وب در دنیای امروز

درک فرق خزش و خراش وب نه تنها برای متخصصان فنی، بلکه برای طیف وسیعی از افراد در زندگی روزمره نیز اهمیت دارد:

۴.۱. برای کاربران عادی

- درک نتایج جستجو: دانستن اینکه خزندههای موتور جستجو چگونه کار میکنند، به کاربران کمک میکند تا بفهمند چرا نتایج خاصی را در جستجوهایشان میبینند و چگونه سایتها برای دیده شدن در این نتایج بهینهسازی میشوند (SEO).

- حفاظت از حریم خصوصی: آگاهی از اینکه دادههای ما چگونه توسط رباتها جمعآوری میشوند، میتواند به درک بهتر خطرات احتمالی و اقدامات لازم برای حفظ حریم خصوصی کمک کند.

۴.۲. برای توسعهدهندگان و متخصصان سئو

- بهینهسازی سایت برای خزش: درک نحوه عملکرد خزندهها به توسعهدهندگان و متخصصان سئو کمک میکند تا سایت خود را به گونهای طراحی کنند که خزندهها بتوانند به راحتی آن را پیمایش کرده و ایندکس کنند. این شامل استفاده صحیح از لینکها، ساختار سایت، نقشه سایت و فایل

robots.txtاست. - رقابتپذیری: متخصصان سئو باید درک کنند که رقبا چگونه از خراش وب برای جمعآوری اطلاعات و بهبود استراتژیهای خود استفاده میکنند.

- تحلیل رقبا: خراش وب ابزار قدرتمندی برای جمعآوری اطلاعات از سایت رقبا، مانند قیمت محصولات، محتوای جدید، نظرات مشتریان و استراتژیهای بازاریابی است.

- جمعآوری داده برای تحلیل: متخصصان داده از خراش وب برای جمعآوری مجموعههای داده بزرگ برای تحلیلهای آماری، پیشبینی روندها و ساخت مدلهای یادگیری ماشین استفاده میکنند.

۴.۳. برای کسبوکارها

- درک بازار: کسبوکارها میتوانند از خراش وب برای جمعآوری اطلاعات در مورد محصولات، قیمتها، نظرات مشتریان و فعالیتهای رقبا استفاده کنند تا تصمیمات استراتژیک بهتری بگیرند.

- پیشنهاد محصولات بهتر: با تحلیل دادههای جمعآوری شده، کسبوکارها میتوانند نیازها و ترجیحات مشتریان را بهتر درک کرده و محصولات و خدمات خود را بهبود بخشند.

- مدیریت شهرت آنلاین: نظارت بر آنچه در مورد برند شما در اینترنت گفته میشود، از طریق خراش وب امکانپذیر است.

۵. روشها و تکنیکهای موثر در خزش و خراش وب

۵.۱. خزش وب

- ساختار منطقی سایت: اطمینان از اینکه ساختار لینکهای داخلی سایت منطقی و قابل دسترسی برای خزندهها است.

- استفاده بهینه از نقشه سایت (Sitemap): ارسال یک فایل

sitemap.xmlجامع و بهروز به موتورهای جستجو. - مدیریت فایل robots.txt: بهینهسازی فایل

robots.txtبرای هدایت صحیح خزندهها و جلوگیری از مسدود شدن تصادفی بخشهای مهم. - سرعت بارگذاری بالا: اطمینان از اینکه صفحات سایت به سرعت بارگذاری میشوند، زیرا خزندهها نیز به سرعت اهمیت میدهند.

- محتوای با کیفیت و منحصر به فرد: موتورهای جستجو به محتوای ارزشمند و جدید اولویت میدهند.

۵.۲. خراش وب

- انتخاب ابزار مناسب: انتخاب ابزار یا زبان برنامهنویسی مناسب برای خراش وب بر اساس پیچیدگی پروژه و نیازهای فنی.

- شناسایی دقیق عناصر: درک ساختار HTML صفحه وب و شناسایی دقیق عناصر حاوی دادههای مورد نیاز.

- استفاده از CSS Selectors یا XPath: اینها روشهای قدرتمندی برای انتخاب عناصر خاص در HTML هستند.

- مدیریت خطا و استثنا: پیشبینی و مدیریت خطاهایی که ممکن است در طول فرآیند خراش وب رخ دهند (مانند تغییر ساختار صفحه، خطا در اتصال).

- مدیریت نرخ درخواست (Rate Limiting): جلوگیری از ارسال درخواستهای بیش از حد به سرور وبسایت هدف برای جلوگیری از مسدود شدن.

- استفاده از پراکسیها (Proxies): برای تغییر IP و جلوگیری از شناسایی و مسدود شدن.

- احترام به robots.txt: همیشه قبل از شروع خراش وب، فایل

robots.txtوبسایت هدف را بررسی کنید. - قوانین کپیرایت و شرایط خدمات: اطمینان از اینکه فعالیت شما با قوانین و مقررات مطابقت دارد.

۶. فواید خزش و خراش وب

۶.۱. فواید خزش وب

- بهبود رتبه در نتایج جستجو: سایتهایی که به خوبی خزش و ایندکس میشوند، شانس بیشتری برای قرار گرفتن در نتایج بالای جستجو دارند.

- افزایش ترافیک ارگانیک: رتبه بهتر به معنای ترافیک بیشتر از طریق جستجوی طبیعی است.

- کشف محتوای جدید: موتورهای جستجو به طور مداوم محتوای جدید را کشف کرده و به کاربران ارائه میدهند.

- دسترسی به اطلاعات گسترده: خزش وب امکان دسترسی به بخش عظیمی از دانش بشری را فراهم میکند.

بیشتر بخوانید: شرح وظایف سئوکار: راهنمای کامل و دقیق

۶.۲. فواید خراش وب

- تصمیمگیری مبتنی بر داده: جمعآوری دادههای واقعی به کسبوکارها کمک میکند تا تصمیمات هوشمندانهتری بگیرند.

- صرفهجویی در زمان و هزینه: اتوماسیون جمعآوری دادهها به جای انجام دستی، بسیار کارآمدتر است.

- تحلیل رقابتی: درک استراتژیهای رقبا و شناسایی فرصتهای بازار.

- مقایسه قیمتها: کاربران و کسبوکارها میتوانند بهترین قیمتها را پیدا کنند.

- پایش بازار: شناسایی روندها، محصولات جدید و تغییرات در صنعت.

- پشتیبانی از تحقیقات علمی و آکادمیک: جمعآوری دادههای مورد نیاز برای پروژههای تحقیقاتی.

۷. نکات کاربردی برای شروع

۷.۱. برای شروع خزش وب (از دیدگاه وبمستر/سئوکار)

- بررسی گزارشهای Google Search Console: این ابزار اطلاعات ارزشمندی در مورد نحوه خزش سایت شما توسط گوگل ارائه میدهد.

- مطالعه راهنمای Google برای وبمسترها: این راهنما شامل نکات و بهترین شیوهها برای بهینهسازی سایت برای خزش و ایندکس شدن است.

- اطمینان از دسترس بودن صفحات مهم: بررسی کنید که آیا خزندهها میتوانند به صفحات کلیدی سایت شما دسترسی پیدا کنند.

- استفاده از ساختار URL دوستانه: URL های کوتاه، توصیفی و بدون کاراکترهای پیچیده.

۷.۲. برای شروع خراش وب (از دیدگاه توسعهدهنده/تحلیلگر داده)

- انتخاب زبان برنامهنویسی: پایتون به دلیل کتابخانههای فراوانش، یک انتخاب عالی است.

- یادگیری کتابخانههای مرتبط: Beautiful Soup برای تجزیه HTML و Requests برای دریافت صفحات وب.

- شروع با پروژههای کوچک: با وبسایتهای ساده شروع کنید و سپس به سراغ پروژههای پیچیدهتر بروید.

- تمرین استخراج دادههای مختلف: انواع دادهها (متن، اعداد، لینکها) را استخراج کنید.

- آشنایی با ساختار HTML: درک تگها، کلاسها و شناسههای HTML ضروری است.

- تجربه کار با API ها: اگر وبسایت مورد نظر API عمومی دارد، استفاده از آن بسیار کارآمدتر و قانونیتر از خراش وب است.

۸. مثال کاربردی: خراش وب برای مقایسه قیمت

فرض کنید میخواهید قیمت یک کتاب خاص را از سه فروشگاه آنلاین مختلف مقایسه کنید.

- شناسایی URL ها: URL صفحات مربوط به آن کتاب را در هر یک از سه فروشگاه پیدا میکنید.

- بررسی ساختار HTML: با استفاده از ابزارهای توسعهدهنده مرورگر (مانند Inspect Element در کروم)، ساختار HTML صفحه را بررسی میکنید تا محل قرارگیری قیمت، نام کتاب و اطلاعات دیگر را پیدا کنید. ممکن است قیمت در یک تگ “ با کلاس “product-price” قرار داشته باشد.

- نوشتن اسکریپت خراش: با استفاده از پایتون و کتابخانههای Requests و Beautiful Soup، اسکریپتی مینویسید که:

- هر URL را دریافت کند.

- محتوای HTML را دانلود کند.

- با استفاده از CSS Selector (مثلاً

span.product-price) قیمت را استخراج کند. - دادههای استخراج شده (نام کتاب، قیمت) را در یک فایل CSV ذخیره کند.

- اجرای اسکریپت: اسکریپت را اجرا میکنید و نتایج در فایل CSV برای مقایسه آماده میشوند.

این یک مثال ساده از خراش وب است که نشان میدهد چگونه میتوان به صورت خودکار دادههای مورد نیاز را جمعآوری کرد.

۹. نتیجهگیری

خزش وب و خراش وب هر دو فرآیندهای مهم در جمعآوری داده از اینترنت هستند، اما اهداف و روشهای متفاوتی دارند. خزش وب توسط موتورهای جستجو برای کشف و فهرستبندی صفحات به منظور ارائه نتایج جستجو انجام میشود، در حالی که خراش وب توسط کاربران و برنامهها برای استخراج دادههای خاص برای اهداف تجاری، تحقیقاتی یا تحلیلی صورت میگیرد. درک فرق خزش و خراش وب برای هر کسی که با دنیای آنلاین سر و کار دارد، از کاربران عادی گرفته تا توسعهدهندگان و متخصصان سئو، حیاتی است. با رعایت اصول اخلاقی و قانونی، هر دو فرآیند میتوانند ابزارهای قدرتمندی برای دسترسی به اطلاعات و بهبود عملکرد وبسایتها باشند.

مفیدترین منابع برای یادگیری بیشتر:

- راهنمای Google برای وبمسترها (این یک لینک معتبر به مستندات گوگل است.)

با تسلط بر مفاهیم خزش و خراش وب، میتوانید گامی مهم در جهت درک عمیقتر و مؤثرتر دنیای دیجیتال بردارید.

دیدگاهتان را بنویسید